A Agência Nacional de Proteção de Dados (ANPD) exigiu que a empresa suspendesse o incentivo financeiro para esse tipo de coleta de dados. Aqui, um especialista em proteção digital detalha as implicações deste negócio Uma nova onda tecnológica tem invadido as redes sociais, mas muitas pessoas ainda não sabem dos riscos que ela representa. O Tik Tok ganhou uma sequência de vídeos de usuários que estavam “vendendo a íris de seus olhos” para uma empresa de inteligência artificial por cerca de 600 reais. O projeto foi desenvolvido pela Tools for Humanity – TFH, que controla a World, da criptomoeda Worldcoin, e levou mais de 400 mil brasileiros a pontos de escaneamento dos olhos em São Paulo em troca de criptoativos, as famosas moedas virtuais, pela leitura e registro da íris — uma informação única e importante, assim como as digitais.

A partir do último sábado (25), entretanto, o projeto não poderá mais remunerar quem participar dele, de acordo uma determinação da Agência Nacional de Proteção de Dados (ANPD) divulgada um dia antes. O órgão é responsável por fiscalizar o cumprimento da Lei Geral da Proteção de Dados (LGPD).

A entidade entendeu que a recompensa pela informação individual “pode interferir na livre manifestação de vontade dos indivíduos, especialmente em casos nos quais potencial vulnerabilidade e hipossuficiência (expressão jurídica que se refere à falta de condições financeiras) tornem ainda maior o peso do pagamento oferecido.”

O projeto ganhou espaço nas redes sociais no início desse ano, já que muitos usuários gravavam todo o processo de escaneamento em troca de recompensa financeira. De vlogs se arrumando até chegar as enormes filas, e claro, as dúvidas sobre o projeto e objetivo começaram a surgir, especialmente no que diz respeito à proteção dos dados individuais. A seguir, especialistas explicam o caso.

Como funciona o escaneamento da íris?

O Worldcoin (WLD), é um projeto cripto de Sam Altman, CEO da OpenAI e criador do ChatGPT, e esteve no Brasil em 2023 com o mesmo propósito atual: escanear a íris dos olhos das pessoas em troca de 25 tokens WLD (aproximadamente R$290). O objetivo, segundo a empresa, é facilitar a identificação de seres humanos em uma era cada vez mais dominada pelo avanço da IA. O sistema se vale dos padrões da íris para criar um código de validação, impossível de ser reproduzido por inteligência artificial.

Apesar de estar presente em 39 países, a empresa já foi banida em países da Europa, como Portugal, Quênia e Índia. Essas suspensões e banimentos aconteceram por preocupações com a falta de clareza no projeto, além de preocupações com a privacidade dos dados.

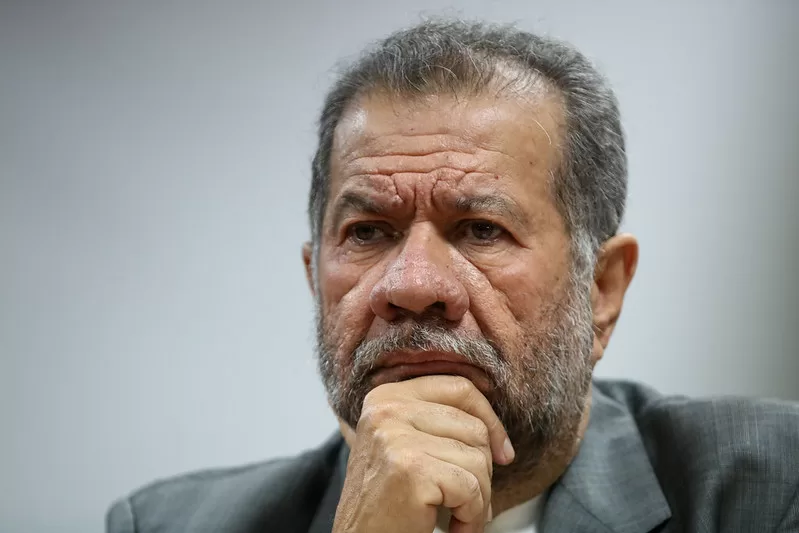

Segundo a LGPD (Lei Geral de Proteção de Dados), existem duas definições para os dados: o Dado Pessoal, que são informações que te identificam, como RG, CPF, Nome, e o dado pessoal sensível, que a legislação protege um pouco mais. “Ele tem um caráter discriminatório e de potencial lesivo muito maior para o titular do dado. A nossa íris, a retina, é considerada um dado pessoal sensível, dentro da caracterização de um dado biométrico”, explica o advogado e especialista em direito digital e proteção de dados Lucas Paglia.

O interesse na recompensa financeira pelo escaneamento no Brasil foi tamanho que a busca “venda da íris” superou o interesse por venda de carros e motos em São Paulo, segundo um relatório recente do Google. No dia 15 de janeiro, a ANPD (Autoridade Nacional de Proteção de Dados) emitiu uma nota oficial pediu esclarecimentos para a Tools For Humanity sobre sua atuação em território nacional e, posteriormente, a autoridade exigiu que o projeto suspendesse o incentivo financeiro em troca desse dado. A empresa foi notificada pelo governo federal na última sexta-feira (24.1) e a medida passou a valer a partir do último sábado (25.01).

Para Lucas, o Brasil tem legislação o suficiente para banir o projeto, como aconteceu em outros países. “A autoridade nacional de proteção de dados, que é uma autoridade hoje respeitada no cenário regulatório de leis brasileiras, já se pronunciou, e já pediu maiores esclarecimentos pra essa empresa, e podemos ter uma novela, um próximo capítulo pra essa discussão relevante”, esclarece o especialista.

Riscos de compartilhamento dos chamados “dados sensíveis”

Sendo a íris dos olhos um dado pessoal sensível, esse tipo de coleta necessida de consentimento, como é feito por meio do aplicativo da empresa. Mas não é tão simples quanto parece: esse consentimento precisa ser qualificado. “Consentimento qualificado é específico e não pode ser genérico. Aplicado ao dado pessoal sensível, é preciso ser mais explicado porque o risco é maior, e é exatamente isso que está sendo discutido: não há uma explicação tão clara, então, não há um consentimento válido, porque as pessoas não estão sendo informadas do potencial do risco e um processo irreversível”, elucida.

Os riscos são inúmeros e provavelmente desconhecidos em sua totalidade, já que a tecnologia hoje no mundo não é a do futuro, como não é a tecnologia do passado. “Coisas que fazemos hoje faz com a tecnologia não eram possíveis de serem pensadas há alguns anos atrás. Nós temos que pensar que a tecnologia é um dos maiores e mais importantes ativos do mundo, e não vai parar de crescer. Os riscos de vender sua íris é não saber o que vai ser feito. A empresa tenta se explicar por meio de seus documentos oficiais, e de fato, traz uma explicação relevante e importante pra essa utilização, mas nós não sabemos o grau de confiabilidade de uma empresa como essa, e até mesmo se eles vão fazer somente isso”, introduz.

“A empresa pode ser comprada, vendida para um governo, empresa concorrente, e a regra do jogo pode mudar. Você precisa informar os seus titulares dessa mudança, mas isso pode não ocorrer. Com um dado tão sensível e único, não é possível mudar nem alterar. Estamos abrindo mão de um dado sensível, com potencial de identificação único no mundo pra essa empresa, sob um risco de por exemplo ter tecnologia no futuro que faça identificação e até reprodução de íris das pessoas”, continua Lucas.

Além do aumento nas buscas sobre “venda da íris, mais de um milhão de pessoas baixou o aplicativo e mais de 400 mil pessoas no Brasil já fizeram o que se chama de “verificação da humanidade”. Isso se deu em especial pelo incentivo financeiro em troca desse dado sensível, que pode ser visto, inclusive, como um tipo de exploração. “Acontece em outros lugares, mercados e situações, não é uma novidade uma pessoa em vulnerabilidade social e econômica ter os seus dados explorados”, alerta.

Situação expõe a falta de informação sobre proteção de dados

O pedido de suspensão do incentivo financeiro feito pela ANPD reforça a tese de que é uma forma exploratória de conseguir esse tipo de informação. Além disso, expõe a falta de informação generalizada a respeito da proteção de dados.

“Existe uma massificação de busca dos nossos dados pessoais, biométricos do nosso rosto, em catracas, entradas de prédios comercias, residenciais, mesmo aqueles que você vai só uma vez. Há um desconhecimento muito grande e as pessoas não acreditam, de certa forma, que existe um risco hoje nessa coleta de dados. Há um certo distanciamento dessa preocupação da população em geral e, de fato, na população de renda mais baixa, o desconhecimento é maior. Essas pessoas estão com outras preocupações: o desemprego, por exemplo. A possibilidade de uma renda extra faz com que se submetam a esse tipo de situação e, naturalmente, pessoas com salários reduzidos veem no projeto uma possibilidade de complementar renda. Estamos falando de quase meio salário mínimo para ter seus olhos escaneados. A diferença social, do ponto de vista econômico, para esse tipo de exploração, é importante”, afirma.

Então, quais cuidados são necessários em relação aos nossos dados sensíveis? “Precisamos entender as questões de transparência e finalidade; o quão transparente eu estou sendo com o tratamento e utilização desses dados, e se a explicação está sendo transparente. Se a finalidade de uso mudar, isso precisa informado e avaliado pelo titular de dados”, resume o expert.

Fonte: Glamour